https://pan.quark.cn/s/e366afb2bcca

总计: 36 个文件夹, 22 个文件

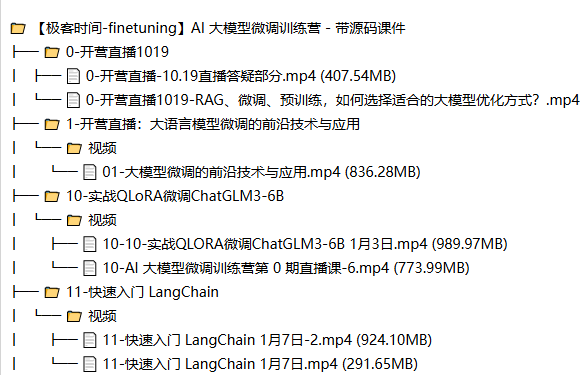

📁 【极客时间-finetuning】AI 大模型微调训练营 – 带源码课件

├── 📁 0-开营直播1019

│ ├── 📄 0-开营直播-10.19直播答疑部分.mp4 (407.54MB)

│ └── 📄 0-开营直播1019-RAG、微调、预训练,如何选择适合的大模型优化方式?.mp4 (1.13GB)

├── 📁 1-开营直播:大语言模型微调的前沿技术与应用

│ └── 📁 视频

│ └── 📄 01-大模型微调的前沿技术与应用.mp4 (836.28MB)

├── 📁 10-实战QLoRA微调ChatGLM3-6B

│ └── 📁 视频

│ ├── 📄 10-10-实战QLORA微调ChatGLM3-6B 1月3日.mp4 (989.97MB)

│ └── 📄 10-AI 大模型微调训练营第 0 期直播课-6.mp4 (773.99MB)

├── 📁 11-快速入门 LangChain

│ └── 📁 视频

│ ├── 📄 11-快速入门 LangChain 1月7日-2.mp4 (924.10MB)

│ └── 📄 11-快速入门 LangChain 1月7日.mp4 (291.65MB)

├── 📁 12-实战基于LangChain和ChatGLM私有化部署聊天机器人

│ └── 📁 视频

│ └── 📄 12-实战基于LangChain和ChatGLM私有化部署聊天机器人1月10日.mp4 (1.38GB)

├── 📁 13-实战私有数据微调ChatGLM3

│ └── 📁 视频

│ └── 📄 13-实战私有数据微调ChatGLM31月18日.mp4 (1.43GB)

├── 📁 14-ChatGPT大模型训川练技术RLHF

│ └── 📁 视频

│ └── 📄 14-ChatGPT大模型训川练技术RLHF1月21日.mp4 (1.14GB)

├── 📁 15-混合专家模型(MoEs)技术揭秘

│ └── 📁 视频

│ └── 📄 15-混合专家模型(MoEs)技术揭秘1月25日.mp4 (942.75MB)

├── 📁 16-大模型分布式训练框架 Microsoft DeepSpeed

│ └── 📁 视频

│ └── 📄 16-大模型分布式训练框架 Microsof Deepspeed1月28日.mp4 (1.42GB)

├── 📁 17-Meta AI 大模型家族 LLaMA

│ └── 📁 视频

│ └── 📄 17-Meta Al 大模型家族 LLaMA1月31日.mp4 (1.13GB)

├── 📁 2-大模型四阶技术总览

│ └── 📁 视频

│ └── 📄 02-AI大模型四阶技术总览.mp4 (1.50GB)

├── 📁 3-大语言模型技术发展与演进

│ └── 📁 视频

│ └── 📄 03-大模型演进.mp4 (1.77GB)

├── 📁 4-大语言模型微调技术揭秘-PEFT

│ └── 📁 视频

│ ├── 📄 04-大模型微调技术揭秘-PEFT.mp4 (2.11GB)

│ └── 📄 04-新录制1月14日.mp4 (864.71MB)

├── 📁 5-大语言模型微调技术揭秘-LoRA

│ └── 📁 视频

│ └── 📄 05-大模型低秩适配(LoRA)技术.mp4 (1.51GB)

├── 📁 6-大模型开发工具库

│ └── 📁 视频

│ └── 📄 06-大模型开发工具.mp4 (1.50GB)

├── 📁 7-实战 Transformers 模型微调

│ └── 📁 视频

│ └── 📄 07-实战 Transformers 模型微调-12月13日.mp4 (1.49GB)

├── 📁 8-实战Transformers模型量化

│ └── 📁 视频

│ └── 📄 08-实战Transformers模型量化.mp4 (1.25GB)

└── 📁 9-大模型高效微调工具HF PEFT

└── 📁 视频

└── 📄 09-大模型高效微调工具HF PEFT12月27日.mp4 (1.33GB)