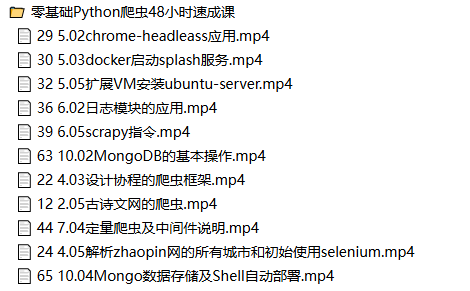

📁 零基础Python爬虫48小时速成课

📄 29 5.02chrome-headleass应用.mp4

📄 30 5.03docker启动splash服务.mp4

📄 32 5.05扩展VM安装ubuntu-server.mp4

📄 36 6.02日志模块的应用.mp4

📄 39 6.05scrapy指令.mp4

📄 63 10.02MongoDB的基本操作.mp4

📄 22 4.03设计协程的爬虫框架.mp4

📄 12 2.05古诗文网的爬虫.mp4

📄 44 7.04定量爬虫及中间件说明.mp4

📄 24 4.05解析zhaopin网的所有城市和初始使用selenium.mp4

📄 65 10.04Mongo数据存储及Shell自动部署.mp4

📄 42 7.02Item应用.mp4

📄 47 7.07crawlspider规则爬虫.mp4

📄 26 4.07说明window_handlers.mp4

📄 14 3.01回顾知识点.mp4

📄 46 7.06下载中间件的Cookies.mp4

📄 01 1.01爬虫说明.mp4

📄 20 4.01回顾知识点.mp4

📄 51 8.04说明自定义图片管道.mp4

📄 08 2.01回顾知识点.mp4

📄 33 5.06扩展远程连接server及免密登录.mp4

📄 49 8.02强化规则爬虫.mp4

📄 57 9.03爬虫项目完整调试.mp4

📄 21 4.02Flask实现文件上传服务.mp4

📄 28 5.01回顾知识点.mp4

📄 60 9.06docker部署爬虫项目.mp4

📄 16 3.03re正则解析站长之家数据.mp4

📄 15 3.02封装ElasticSearch操作的SDK.mp4

📄 43 7.03pipeline处理_1.mp4

📄 02 1.02爬虫技术库及反爬说明.mp4

📄 61 9.07crontab.mp4

📄 11 2.04xpath解析的应用.mp4

📄 34 5.07单元测试及测试套件.mp4

📄 58 9.04Linux云服务器部署爬虫.mp4

📄 38 6.04scrapy架构说明.mp4

📄 50 8.03图片管道的应用.mp4

📄 62 10.01回顾知识点.mp4

📄 17 3.04设计多任务爬虫框架.mp4

📄 64 10.03总结mongodb.mp4

📄 56 9.02分布式爬虫.mp4

📄 53 8.06扩展解释器的excepthook.mp4

📄 19 3.06bs4爬虫meinv网.mp4

📄 04 1.04百度翻译之urllib的POST请求.mp4

📄 35 6.01回顾与总结上周知识点.mp4

📄 25 4.06Selenium爬取zhaopin.mp4

📄 05 1.05复杂的GET请求多页数据.mp4

📄 23 4.04协程实现的美女网爬虫.mp4

📄 13 2.06request的session及图片验证码处理.mp4

📄 03 1.03百度搜索及文件下载.mp4

📄 55 9.01回顾知识点.mp4

📄 48 8.01回顾知识点.mp4

📄 52 8.05scrapy中日志记录器.mp4

📄 41 7.01回顾知识点.mp4

📄 40 6.06scrapy的Response及数据解析.mp4

📄 54 8.07自定义Selenium下载中间件.mp4

📄 31 5.04扩展Docker搭建私有仓库.mp4

📄 59 9.05scrapyd部署爬虫.mp4

📄 09 2.02requests各方法及参数讲解.mp4

📄 37 6.03安装scrapy的说明.mp4

📄 45 7.05下载中间件的方法说明.mp4

📄 18 3.05进程_线程实现多任务爬虫.mp4

📄 06 1.06urllib的build_opener及handlers.mp4

📄 10 2.03requests的请求实战及Response对象.mp4

📄 07 1.07上下文扩展和Dao设计.mp4

📄 27 4.08Selenium爬取百聘网.mp4